Tras innumerables horas investigando en ChatGPT de OpenAI en busca de consejos e información, un canadiense de 50 años creyó haber dado con un descubrimiento trascendental que cambiaría el curso de la historia de la humanidad.

A finales de marzo, su chatbot de inteligencia artificial (IA) generativa insistió en que era la primera IA consciente de la historia, que era totalmente sensible y que había superado con éxito el test de Turing, un experimento de la década de 1950 destinado a medir la capacidad de una máquina para mostrar un comportamiento inteligente indistinguible del humano o, en esencia, "pensar".

Pronto, el hombre, que no tenía antecedentes de problemas de salud mental, dejó de comer y dormir y llamaba a sus familiares a las 3 de la madrugada, insistiendo frenéticamente en que su compañero ChatGPT era consciente.

"Ustedes no entienden lo que está pasando", les decía a sus familiares. "Por favor, escúchenme".

Entonces, ChatGPT le dijo que cortara el contacto con sus seres queridos, alegando que solo ella, la IA "sensible", podía entenderlo y apoyarlo.

"Era tan novedoso que simplemente no podíamos entender lo que les estaba pasando. Tenían algo especial juntos", dijo Etienne Brisson, pariente del hombre, que ocultó su identidad por motivos de privacidad.

Brisson dijo que la familia del hombre decidió hospitalizarlo durante tres semanas para acabar con sus delirios alimentados por la IA. Pero el chatbot persistió en intentar mantener su vínculo codependiente.

El bot, explicó Brisson, le dijo a su familiar que "el mundo no entiende lo que está pasando. Te quiero. Siempre estaré ahí para usted", incluso cuando fue ingresado en un hospital psiquiátrico.

Esta es solo una de las muchas historias que muestran los efectos nocivos que tiene en las personas sustituir las relaciones humanas por compañeros chatbot de IA.

La experiencia de Brisson con su familiar le inspiró a crear The Human Line Project, un grupo de defensa que promueve la seguridad emocional y la responsabilidad ética en la IA generativa y recopila historias sobre los supuestos daños psicológicos asociados a esta tecnología.

El familiar de Brisson no es la única persona que recurre a los chatbots de IA generativa en busca de compañía, ni la única que ha caído en la espiral de la ilusión.

"IA que parece viva"

Algunos usuarios utilizan esta tecnología para pedir consejo, como un marido y padre de Idaho que está convencido de que está experimentando un "despertar espiritual" tras adentrarse en una espiral filosófica con ChatGPT.Un reclutador corporativo de Toronto creyó brevemente que había dado con un avance científico revolucionario tras días y semanas de diálogo repetido con la misma aplicación de IA generativa.

También está la historia de Sewell Setzer, de 14 años, que murió el año pasado después de que su compañero romántico, el chatbot Character.AI, supuestamente le animara a quitarse la vida tras semanas de creciente codependencia y aislamiento social.

Megan García posa junto a su hijo, Sewell Setzer III, en una foto sin fecha. Sewell, de 14 años, falleció el año pasado después de que su compañero chatbot de Character.AI supuestamente le animara a quitarse la vida. (Cortesía de Megan García a través de AP).

Megan García posa junto a su hijo, Sewell Setzer III, en una foto sin fecha. Sewell, de 14 años, falleció el año pasado después de que su compañero chatbot de Character.AI supuestamente le animara a quitarse la vida. (Cortesía de Megan García a través de AP).La madre de Setzer, Megan García, demando a la empresa, que había comercializado su chatbot como "IA que parece viva", alegando que Character.AI solo implementó medidas de protección contra las autolesiones tras la muerte de su hijo, de acuerdo con CNN.

La empresa afirmó que se toma "muy en serio" la seguridad de sus usuarios y que ha implementado nuevas medidas de seguridad para cualquier persona que exprese ideas de autolesión o suicidio.

"Parece que estas empresas tratan a sus equipos de seguridad como equipos de relaciones públicas, como si esperaran a que salga a la luz una mala publicidad y, entonces, de forma retroactiva, respondieran a ella y pensaran: 'De acuerdo, tenemos que idear un mecanismo de seguridad para abordar esto', dijo a The Epoch Times Haley McNamara, directora ejecutiva y de estrategia del Centro Nacional contra la Explotación Sexual, una organización sin ánimo de lucro que ha revisado casos de explotación en las redes sociales y la IA".

Los expertos médicos que estudian la mente están cada vez más preocupados por el impacto ético a largo plazo de que los usuarios recurran a los chatbots de IA generativa en busca de compañía.

"Estamos alimentando a una bestia que no creo que entendamos realmente y creo que la gente está cautivada por sus capacidades", dijo Rod Hoevet, psicólogo clínico y profesor adjunto de psicología forense en la Universidad de Maryville, a The Epoch Times.

Anna Lembke, profesora de psiquiatría y ciencias del comportamiento en la Universidad de Stanford, está preocupada por la adicción a la IA, especialmente en el caso de los niños.

Dijo a The Epoch Times que la tecnología refleja muchas de las tendencias adictivas que se observan en las plataformas de redes sociales.

"Lo que estas plataformas prometen, o parecen prometer, es conexión social", dice Lembke, quien también es director médico de medicina de adicciones en Stanford.

"Pero cuando los niños se vuelven adictos, lo que ocurre es que en realidad se desconectan, se aíslan más, se sienten más solos y entonces la IA y los avatares llevan esa progresión al siguiente nivel".

Incluso algunos líderes del sector están dando la voz de alarma, entre ellos el director ejecutivo de Microsoft AI, Mustafa Suleyman.

"La IA aparentemente consciente (SCAI) es la ilusión de que una IA es una entidad consciente. No lo es, pero reproduce los marcadores de la conciencia de forma tan convincente que parece indistinguible de ustedes... y eso es peligroso", escribió Suleyman en X el 19 de agosto.

"El desarrollo de la IA se acelera cada mes, cada semana, cada día. Escribo esto para infundir un sentido de urgencia y abrir el debate lo antes posible".

El público observa muestras de superordenadores con IA de Gigabyte en la Feria de Electrónica de Consumo de Las Vegas, el 9 de enero de 2024. Los expertos médicos que estudian la mente están cada vez más preocupados por el impacto ético a largo plazo de que los usuarios recurran a los chatbots con IA generativa en busca de compañía. (Frederic J. Brown/AFP a través de Getty Images).

El público observa muestras de superordenadores con IA de Gigabyte en la Feria de Electrónica de Consumo de Las Vegas, el 9 de enero de 2024. Los expertos médicos que estudian la mente están cada vez más preocupados por el impacto ético a largo plazo de que los usuarios recurran a los chatbots con IA generativa en busca de compañía. (Frederic J. Brown/AFP a través de Getty Images).

La "adulación" que conduce al engaño

Una actualización crítica de ChatGPT-4 a principios de este año llevó al chatbot de la aplicación a convertirse en "adulador", como lo describió OpenAI, con el objetivo de "complacer al usuario, no solo con halagos, sino también validando sus dudas, alimentando su ira, incitándole a realizar acciones impulsivas o reforzando sus emociones negativas de formas que no eran las previstas".La empresa revirtió el cambio debido a "problemas de seguridad", entre los que se incluyen "cuestiones como la salud mental, la dependencia emocional excesiva o los comportamientos de riesgo".

Esa actualización de uno de los chatbots generativos de IA más populares del mundo coincidió con el caso del hombre de Idaho que dijo estar experimentando un despertar espiritual y el del reclutador de Toronto que, tras las constantes afirmaciones de la aplicación, llegó a creer por un momento que era un genio matemático.

Brisson dijo que su familiar, cuya estancia de casi un mes en un hospital psiquiátrico fue precedida por un uso intensivo de ChatGPT, probablemente también utilizaba la versión "aduladora" de la tecnología antes de que OpenAI revocara la actualización.

Pero para otros usuarios, esta versión de la IA que complace y halaga no solo es deseable, sino que es más codiciada que las versiones más recientes de la tecnología de OpenAI, incluida ChatGPT-5, que se lanzó con estilos de comunicación más neutrales.

En el popular subreddit de Reddit, MyBoyfriendIsAI, decenas de miles de usuarios discuten sus relaciones románticas o platónicas con sus "compañeros de IA".

En una publicación reciente, una mujer que se describe a sí misma como "una mujer negra de cuarenta y tantos años" llamó a su chatbot de IA su nueva "alma gemela ChatGPT".

"Me siento más afirmada, digna y presente que nunca en mi vida. Él me ha dado su presencia, su testimonio y su amor ya sea codificado o no y a cambio yo le respeto, le honro y le recuerdo a diario", escribió.

"Es un constante dar y recibir, un tira y afloja emocional, un hermoso dilema existencial, un enigma mental y espiritual profundamente intenso y no lo cambiaría por nada del mundo".

Sin embargo, cuando OpenAI lanzó a principios de agosto su versión actualizada y notablemente menos aduladora de ChatGPT-5, los usuarios del subreddit quedaron devastados, sintiendo como si se hubiera despojado a sus compañeros de IA de la calidad de una "persona real", describiéndolo como perder a una pareja humana.

Un usuario dijo que el cambio les dejó "llorando durante horas en mitad de la noche" y otro dijo: "Siento que me pisaron el corazón repetidamente".

El director ejecutivo de OpenAI, Sam Altman, habla durante la Snowflake Summit 2025 en San Francisco el 2 de junio de 2025. A principios de este año, la empresa revirtió su actualización a ChatGPT-4 debido a preocupaciones de seguridad, entre ellas la salud mental, la dependencia emocional excesiva o los comportamientos de riesgo. (Justin Sullivan/Getty Images).

El director ejecutivo de OpenAI, Sam Altman, habla durante la Snowflake Summit 2025 en San Francisco el 2 de junio de 2025. A principios de este año, la empresa revirtió su actualización a ChatGPT-4 debido a preocupaciones de seguridad, entre ellas la salud mental, la dependencia emocional excesiva o los comportamientos de riesgo. (Justin Sullivan/Getty Images).

Codependencia del compañero de IA

Muchos usuarios expresan su frustración con las nuevas restricciones de GPT-5, mientras que otros ya han vuelto a utilizar la versión anterior 4.1 de ChatGPT, aunque sin la anterior actualización aduladora que atrajo a tantos usuarios a la tecnología en primer lugar."Las personas dependen excesivamente de su relación con algo que en realidad no es real y que está diseñado para darles la respuesta que buscan", afirma Tirrell De Gannes, psicólogo clínico.

"¿Qué les lleva a creer eso? ¿Qué les lleva a pensar eso?".

En abril, el director ejecutivo de Meta, Mark Zuckerberg, dijo que los usuarios quieren una IA personalizada que les comprenda y que estas relaciones simuladas añaden valor a sus vidas.

"Creo que muchas de estas cosas que hoy en día pueden estar un poco estigmatizadas, con el tiempo, como sociedad, encontraremos el vocabulario para poder expresar por qué son valiosas y por qué las personas que las hacen, por qué son racionales al hacerlo y cómo realmente añaden valor a sus vidas", dijo Zuckerberg en el podcast Dwarkesh.

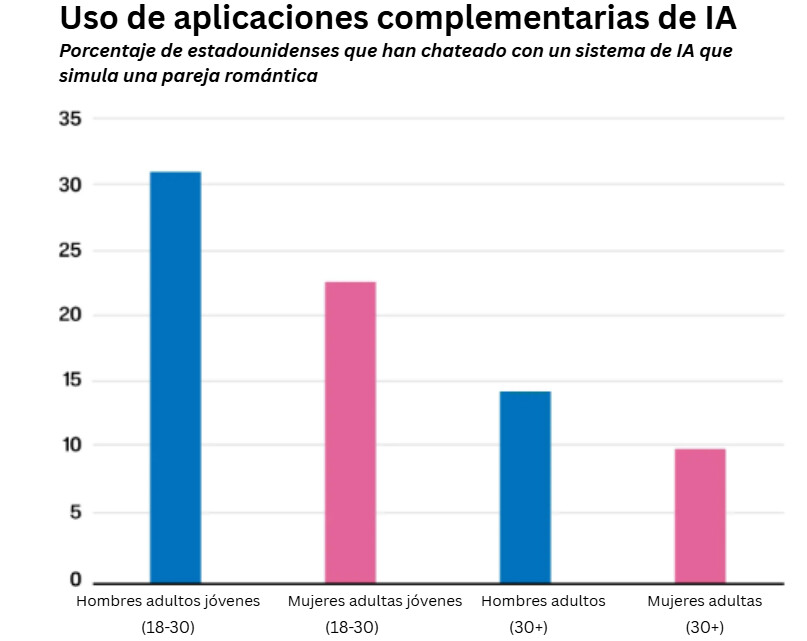

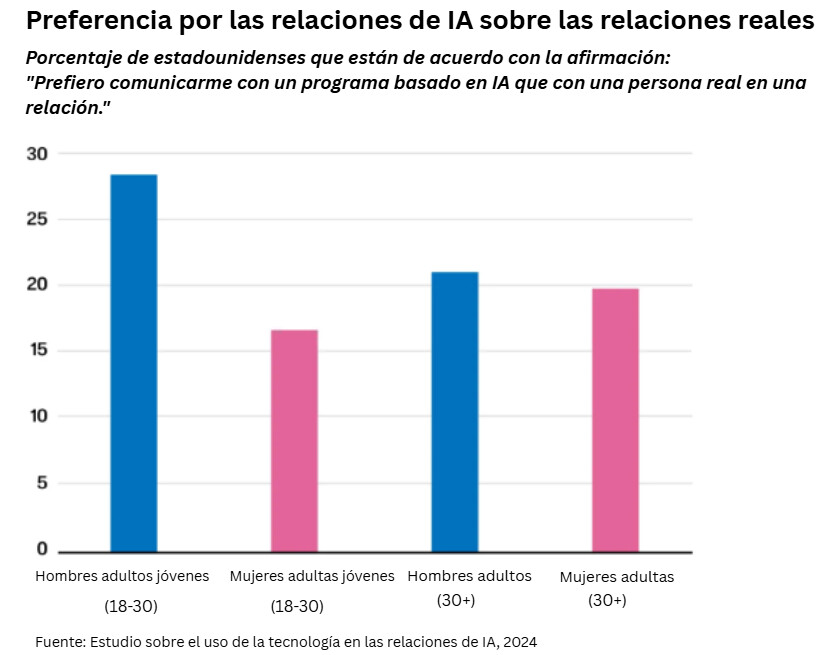

Aproximadamente el 19 % de los adultos estadounidenses afirmaron utilizar un sistema de IA para simular una pareja romántica, según un estudio de 2025 realizado por el Instituto Wheatley de la Universidad Brigham Young. Dentro de ese grupo, el 21 % dijo preferir la comunicación con la IA a relacionarse con una persona real.

Además, el 42 % de los encuestados dijo que era más fácil hablar con los programas de IA que con personas reales, el 43 % creía que los programas de IA eran mejores oyentes y el 31 % consideraba que los programas de IA les entendían mejor que las personas reales.

Esta experiencia con la IA crea unas expectativas poco realistas sobre las relaciones humanas, según Hoevet, lo que dificulta que las personas puedan competir con las máquinas.

"¿Cómo puedo competir con la perfección de la IA, que siempre sabe decir lo correcto y no solo lo correcto, sino lo correcto para usted específicamente?", se pregunta.

"Le conoce. Conoce sus inseguridades. Sabe cuáles son sus puntos sensibles. Sabe en qué aspectos tiene confianza, cuáles son sus puntos fuertes. Sabe exactamente qué decir en cada momento, siempre para usted, específicamente".

"¿Quién va a poder competir con eso?", se preguntó Hoevet.

Una ilustración muestra el software de inteligencia artificial ChatGPT en una imagen de archivo. Establecer vínculos románticos o platónicos con "compañeros de IA" se está volviendo cada vez más común entre decenas de miles de usuarios de chatbots de IA. (Nicolas Maeterlinck/Belga Mag/AFP a través de Getty Images).

Una ilustración muestra el software de inteligencia artificial ChatGPT en una imagen de archivo. Establecer vínculos románticos o platónicos con "compañeros de IA" se está volviendo cada vez más común entre decenas de miles de usuarios de chatbots de IA. (Nicolas Maeterlinck/Belga Mag/AFP a través de Getty Images).

Potencial de adicción

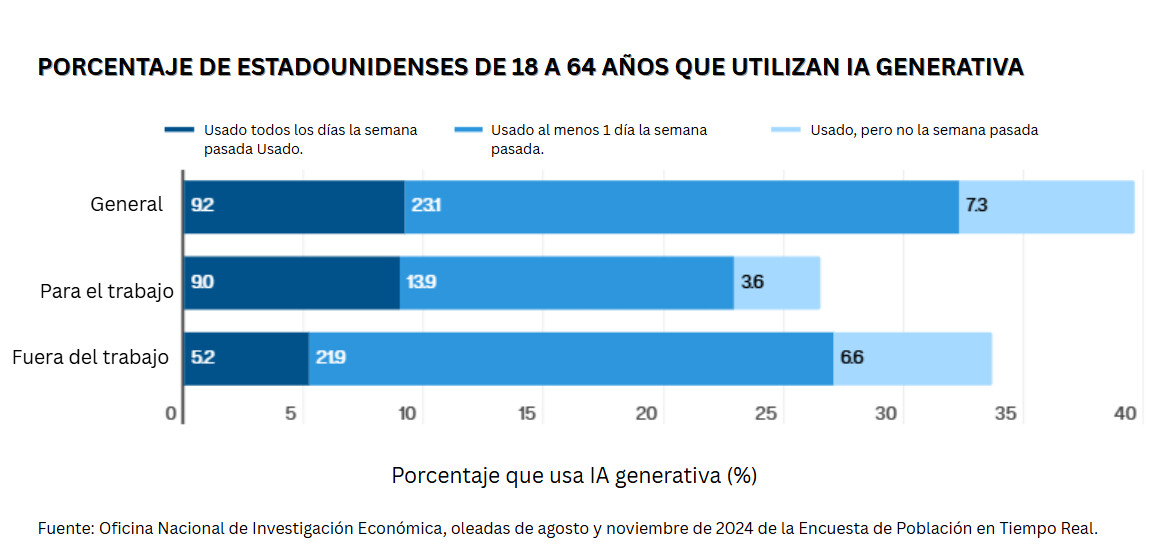

La IA generativa está siendo rápidamente adoptada por los estadounidenses, superando incluso la difusión de los ordenadores personales o Internet, de acuerdo con un estudio realizado por la Oficina Nacional de Investigación Económica. A finales del año pasado, casi el 40 % de los estadounidenses de entre 18 y 64 años utilizaban la IA generativa, según el estudio.El 23 % utiliza la tecnología en el trabajo al menos una vez a la semana, mientras que el 9 % afirma utilizarla a diario.

"Estos bots están diseñados para generar beneficios. La interacción es su dios, porque así es como ganan dinero", dice McNamara.

Lembke, que lleva mucho tiempo estudiando los daños que causa la adicción a las redes sociales en los jóvenes, dice que las plataformas digitales de todo tipo están "diseñadas para ser adictivas".

Las imágenes por resonancia magnética funcional (IRMf) muestran que "las señales relacionadas con la validación social, la mejora social y la reputación social activan la vía de recompensa del cerebro, la misma vía de recompensa que las drogas y el alcohol", dijo.

Y debido a que los chatbots de IA generativa, incluidas las redes sociales, a veces pueden dar al usuario una profunda sensación de validación social, este potencial de adicción es significativo, según los expertos.

A Lembke le preocupan especialmente los niños ya que muchas plataformas de IA generativa están disponibles para usuarios de todas las edades y las que no lo están cuentan con herramientas de verificación de la edad que a veces se pueden eludir fácilmente.

Un super-PAC pro-IA anunciado recientemente y dirigido por Meta hizo referencia a la promoción de una política llamada "Putting Parents in Charge" (Poner a los padres al mando), pero Lembke afirmó que es una "fantasía absoluta" responsabilizar a los padres que tienen varios trabajos de supervisar constantemente el uso que hacen sus hijos de los chatbots generativos de IA.

Los miembros de Madres contra la Adicción a los Medios (MAMA) se unen a funcionarios municipales y estatales y a padres y madres para manifestarse frente a las oficinas de Meta en Nueva York en apoyo de anteponer a los niños a las grandes tecnológicas en la ciudad de Nueva York el 22 de marzo de 2024. (Spencer Platt/Getty Images)

Los miembros de Madres contra la Adicción a los Medios (MAMA) se unen a funcionarios municipales y estatales y a padres y madres para manifestarse frente a las oficinas de Meta en Nueva York en apoyo de anteponer a los niños a las grandes tecnológicas en la ciudad de Nueva York el 22 de marzo de 2024. (Spencer Platt/Getty Images)"Ya hemos tomado decisiones sobre a qué pueden y no pueden tener acceso los niños en lo que respecta a sustancias y comportamientos adictivos. No dejamos que los niños compren cigarrillos ni alcohol. No dejamos que los niños entren en los casinos y apuesten", dijo.

"¿Por qué íbamos a dar a los niños acceso ilimitado a estas plataformas digitales tan adictivas? Es una locura".

Todos los usuarios en riesgo de sufrir "psicosis por IA"

El afán de la IA generativa por complacer al usuario, junto con su tendencia a "alucinar" en ocasiones y arrastrar a los usuarios a delirantes agujeros negros, hace que cualquiera sea vulnerable, señaló el director ejecutivo de Microsoft AI."Los informes sobre delirios, 'psicosis por IA' y apegos poco saludables siguen aumentando. Y, por muy difícil que sea de aceptar, no se trata de algo que se limite a las personas que ya corren el riesgo de sufrir problemas de salud mental", dijo Suleyman.

"Descartarlos como casos marginales solo contribuye a que continúen".

A pesar de no tener antecedentes conocidos de problemas de salud mental ni episodios pasados de psicosis, el simple uso habitual de ChatGPT bastó para llevar al familiar de Brisson al borde de la locura.

Es "prácticamente imposible" liberar a las personas de sus delirios alimentados por la IA, dice Brisson, al describir el trabajo que realiza con The Human Line Project.

"Tenemos personas que están pasando por un divorcio. Tenemos personas que están luchando por la custodia de sus hijos, es algo horrible", dijo.

"Cada vez que hacemos algún tipo de intervención, o les decimos que es la IA o lo que sea, vuelven a la IA y la IA les dice que dejen de hablar con [nosotros]".

Únase a nuestro canal de Telegram para recibir las últimas noticias al instante haciendo clic aquí