Ahora que decenas de millones de niños vuelven al colegio, padres y profesores se enfrentan a la pregunta de cuánta inteligencia artificial (IA) es demasiada.

Según el autor Joe Allen, el sistema educativo será uno de los principales laboratorios para el experimento global de IA.

"Las escuelas, en la medida en que impongan o fomenten la adopción de la IA, se convertirán en enormes placas de Petri en las que descubriremos si es mejor mantener las normas culturales tradicionales o si convertimos a todos los niños posibles en ciborgs", declaró a The Epoch Times.

Nadie sabe cuáles serán los efectos a largo plazo, afirmó Allen, autor de "Aeón oscuro: El Transhumanismo y la Guerra Contra la Humanidad".

Del mismo modo que la tecnología popular, como la televisión y las radios transistor portátiles, difundió la música y el mensaje de los movimientos subculturales que influyeron en una generación de niños para que se alejaran de las normas culturales de sus padres durante los años 60, él cree que la IA también podría afectar a "una generación de niños que están acostumbrados a interactuar con máquinas, básicamente como si fueran personas".

Joe Allen, autor de "Aeón oscuro: El Transhumanismo y la guerra contra la humanidad", analiza los posibles riesgos de la IA en el aula. (Cortesía de Dan Fluette).

Joe Allen, autor de "Aeón oscuro: El Transhumanismo y la guerra contra la humanidad", analiza los posibles riesgos de la IA en el aula. (Cortesía de Dan Fluette).Algunos profesores ya creen que la IA tendrá un impacto negativo en la integridad académica, según una encuesta realizada en 2024 a 850 docentes publicada por The Wiley Network. Casi la mitad, el 47 %, de los más de 2000 estudiantes encuestados afirmó que copiar ya era más fácil con la IA.

Los profesores encuestados afirman que muchos de los trabajos que entregan los estudiantes se parecen mucho entre sí o no parecen estar escritos con la voz propia del estudiante.

Incluso los estudiantes universitarios admiten que la IA les está embruteciendo. En un estudio de 2024 publicado en la revista European Research Studies Journal, el 83 % de los estudiantes encuestados, en su mayoría universitarios, expresaron su preocupación por que la IA debilite la capacidad de pensar de forma independiente.

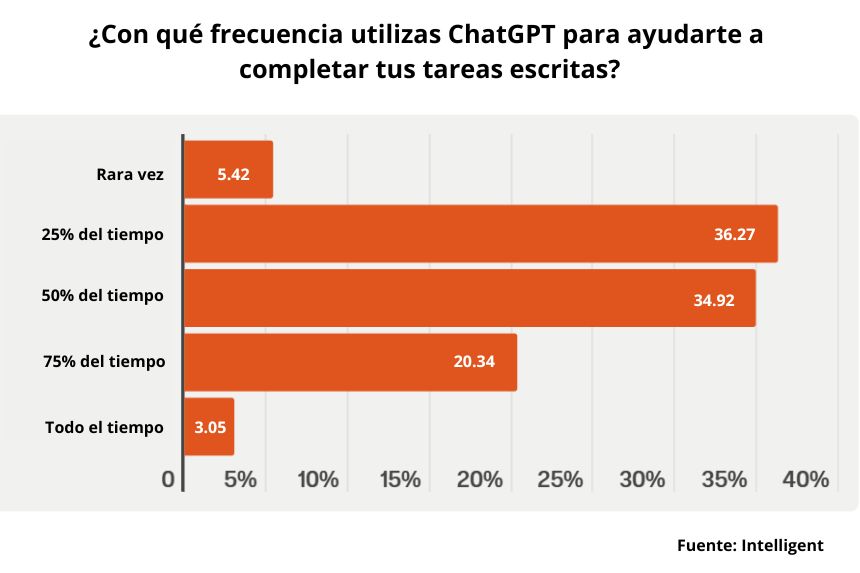

Según una encuesta realizada en 2023 a 1000 estudiantes universitarios estadounidenses por la revista online Intelligent, casi un tercio afirmó haber utilizado ChatGPT para completar los deberes escritos, y casi el 60 % dijo haberlo utilizado para más de la mitad de sus trabajos. La encuesta reveló que, de estos estudiantes, tres de cada cuatro creen que se trata de hacer trampa, pero utilizan la IA de todos modos.

En varias encuestas, la mayoría de los padres expresaros su preocupación por los efectos del uso de la IA en sus hijos.

Un estudio realizado por DoodleLearning el año pasado reveló que aproximadamente el 80 % de los 1000 padres con hijos en edad escolar estaban preocupados por el impacto de la IA en la educación. Los padres encuestados también estaban preocupados por la privacidad, la seguridad de los datos y el plagio.

En julio, el Departamento de Educación animó a las escuelas a enseñar a los niños a utilizar la IA de forma responsable y a utilizarla para "personalizar el aprendizaje" de "los estudiantes de todos los niveles".

"Tu cerebro en ChatGPT"

Shannon Kroner, psicóloga clínica, terapeuta educativa desde hace más de 20 años y autora de libros infantiles, cree que la IA afecta al pensamiento crítico y "deshumaniza tanto al profesor como al niño". A Shannon Kroner, terapeuta educativa y autora de libros infantiles, le preocupa que el uso de IA en las escuelas pueda obstaculizar el pensamiento crítico de los niños. (Cortesía de Shannon Kroner).

A Shannon Kroner, terapeuta educativa y autora de libros infantiles, le preocupa que el uso de IA en las escuelas pueda obstaculizar el pensamiento crítico de los niños. (Cortesía de Shannon Kroner).Kroner, que impartió clases de biología en secundaria y humanidades en la universidad, afirma que la IA reduce la educación de un aprendizaje saludable basado en las relaciones entre profesores y alumnos a una fría transacción.

"La IA crea una pereza intelectual tanto en el profesor como en el alumno, y... una erosión de la curiosidad, un retraso en el desarrollo cognitivo y una reducción de la capacidad para resolver problemas. Debilita la lógica y el razonamiento", declaró a The Epoch Times.

"Los alumnos no tendrán que investigar ni profundizar en los estudios necesarios para defender su punto de vista sobre lo que sea que tengan que demostrar", afirmó.

Los educadores consultan cada vez más a la IA para desarrollar planes de estudio porque les facilita el trabajo, pero esto acabará por restarles poder en su función como profesores, ya que los alumnos confían cada vez más "en lo que dice un robot".

"Realmente vamos a perder esa conexión entre profesor y alumno", afirmó. "Cuanto más natural se vuelva el uso de la IA, más recurrirán los alumnos a ella en busca de respuestas, y ya no importará cuál sea el tema de debate entre el profesor y el alumno. Probablemente, el debate acabará siendo obsoleto. No habrá debate".

Un reciente estudio del MIT, titulado "Tu cerebro en ChatGPT: Acumulación de deuda cognitiva al utilizar un asistente de IA para tareas de redacción de ensayos", analizó si la IA perjudica las habilidades de pensamiento crítico.

El estudio correlacionó datos cognitivos y neurológicos de 54 estudiantes, con edades comprendidas entre los 18 y los 39 años. Se utilizó la electroencefalografía (EEG) para registrar la actividad cerebral. Los estudiantes se dividieron en tres grupos: Uno que utilizaba ChatGPT de OpenAI, otro que utilizaba el motor de búsqueda de Google y el tercero que solo utilizaba su cerebro y se les pidió que escribieran varios ensayos.

El estudio reveló que los usuarios de ChatGPT, o los usuarios de IA con modelos de lenguaje grandes, tenían la menor participación cerebral y a menudo recurrían a respuestas copiadas y pegadas.

Un campus del Distrito Escolar Unificado de Los Ángeles en Los Ángeles, el 8 de enero de 2024. Las escuelas utilizan cada vez más la IA para la calificación automatizada, la planificación de clases, los exámenes y la tutoría virtual mediante chatbots. (John Fredricks/The Epoch Times)

Un campus del Distrito Escolar Unificado de Los Ángeles en Los Ángeles, el 8 de enero de 2024. Las escuelas utilizan cada vez más la IA para la calificación automatizada, la planificación de clases, los exámenes y la tutoría virtual mediante chatbots. (John Fredricks/The Epoch Times)Durante cuatro meses, los usuarios de modelos de lenguaje grandes "obtuvieron resultados consistentemente inferiores" a nivel neuronal, lingüístico y conductual. Estos resultados suscitan preocupación sobre las implicaciones educativas a largo plazo de la dependencia de los modelos de lenguaje grandes (LLM) y subrayan la necesidad de investigar más a fondo el papel de la IA en el aprendizaje", concluye el estudio.

El grupo que utilizó la IA se mostró "completamente aburrido" y presentó una menor capacidad de recuerdo, con menos actividad cerebral, especialmente en el hipocampo, donde se forman los recuerdos, según Allen.

En esencia, dijo, el estudio confirma que "la IA hace que las personas sean más estúpidas. Si confías en una máquina para que piense por ti, no pensarás tan bien".

Preocupaciones por la salud mental, amigos artificiales

Probablemente no se conocerán los efectos de la IA en la humanidad hasta dentro de muchos años, al igual que los efectos a largo plazo de la respuesta del gobierno a la pandemia de COVID-19, afirmó Allen.Los confinamientos por la pandemia, el teletrabajo y el impulso del aprendizaje virtual que se produjo como consecuencia de ello consolidaron la tendencia a alejarse de la interacción presencial.

El uso extensivo de las redes sociales, especialmente durante la pandemia, fue ampliamente identificado en estudios como un factor que contribuye a los problemas de salud mental de los jóvenes. A Kroner le preocupa que añadir la IA a la ecuación pueda agravar el problema.

Las empresas de IA están promocionando amigos artificiales robóticos y chatbots como compañeros para los niños que se vieron aislados de sus amigos reales durante la pandemia y ahora la gente está recurriendo a la IA para recibir terapia, dijo.

El avance tecnológico hacia los robots humanoides y el fomento de los amigos artificiales para los niños plantea otras cuestiones, como si estos productos de IA pueden aliviar la soledad de los niños tímidos o con dificultades sociales, o si los aislará aún más de otros niños y de actividades físicas saludables, como jugar al aire libre y practicar deporte.

Según la Academia Americana de Pediatría (AAP), las recetas de antidepresivos para adolescentes y adultos jóvenes ya estaban aumentando antes de COVID-19, pero a partir de marzo de 2020, se dispararon un 60 % adicional.

Un robot educativo con inteligencia artificial de iPal se exhibe en el stand de AvatarMind durante la feria de electrónica de consumo CES 2019 en el Centro de Convenciones de Las Vegas el 8 de enero de 2019. (Robyn Beck/AFP vía Getty Images).

Un robot educativo con inteligencia artificial de iPal se exhibe en el stand de AvatarMind durante la feria de electrónica de consumo CES 2019 en el Centro de Convenciones de Las Vegas el 8 de enero de 2019. (Robyn Beck/AFP vía Getty Images).Kroner teme que la IA destruya la inocencia de la infancia, entre otras cosas, a través de la sexualización de los chatbots, como el personaje de chatbot basado en X, "Ani".

Los sistemas de IA también entrañan riesgos para la privacidad de los niños que introducen datos personales en ellos, según Kroner.

"¿Quién recopila todos los datos y pueden esos datos ser explotados en algún momento?", se pregunta. "¿Quién conserva esos datos?".

Aunque la frase "si entra basura, sale basura" sigue aplicándose en cierta medida a la informática, la IA es muy diferente, afirmó. En la informática clásica, "basura entra, basura sale" significaba que "si se introducía un montón de basura en un programa basado en reglas, se podía predecir la basura que saldría a partir de la basura que se había introducido".

Pero se puede introducir "basura y oro" en grandes modelos lingüísticos y estos pueden seleccionar el oro de la basura. A diferencia de los motores de búsqueda básicos, que sirven como simples herramientas de consulta de bases de datos, la IA tiene mente propia en el sentido de que puede navegar por su propio camino a través de los datos dentro de unos límites a medida que los usuarios hacen preguntas, lo que le permite descubrir mucha información útil que de otro modo podría haber quedado oculta, dijo Allen.

En cierto modo, la IA funciona como un cerebro humano con un grado de libertad y aleatoriedad, pero lo hace de una "manera muy extraña", afirmó.

"Solo las tasas de alucinaciones deberían ser suficientes para alarmar a los padres de que no va a ser el supergenio que prometen personas como Sam Altman", dijo Allen.

(Ilustración de The Epoch Times, Getty Images).

(Ilustración de The Epoch Times, Getty Images).La IA es propensa a la confabulación conocida como "alucinaciones", que presenta información falsa o engañosa no basada en experiencias perceptivas y lo hace de manera convincente.

En pruebas realizadas por la empresa, los últimos modelos 03 y 04-mini de OpenAI alucinaron el 51 % y el 79 % de las veces. Y en un estudio de 2024 que evaluaba el uso de la IA en la profesión jurídica, las tasas de alucinación alcanzaron hasta el 88 %.

Allen señaló un ejemplo de la última versión 4.5 de ChatGPT, que abandonó las barreras de seguridad destinadas a impedir ciertos debates e instruyó a los usuarios sobre cómo realizar sacrificios a Molech, una antigua deidad históricamente asociada con el sacrificio de niños.

Hubo muchos otros casos de personas que traspasaron las barreras de seguridad de la IA. En un ejemplo reciente, a principios de julio, el chatbot Grok generó y difundió inesperadamente una serie de publicaciones antisemitas.

"La tecnología en sí misma tiene un elemento de aleatoriedad. La naturaleza no determinista del sistema significa que, bajo esas barreras de seguridad, se esconde una especie de identidad y las barreras de seguridad funcionan como una especie de superyó", dijo Allen. "No hace falta ser un usuario experto para superar muchas de esas barreras de seguridad. Solo se necesitan unos sencillos trucos".

Ilustración del chatbot generativo de IA Grok en una imagen de archivo. A principios de julio, el chatbot generó y difundió inesperadamente publicaciones antisemitas, lo que generó preocupación por las vulnerabilidades de las barreras de seguridad de la IA. (Riccardo Milani/Hans Lucas/AFP vía Getty Images)

Ilustración del chatbot generativo de IA Grok en una imagen de archivo. A principios de julio, el chatbot generó y difundió inesperadamente publicaciones antisemitas, lo que generó preocupación por las vulnerabilidades de las barreras de seguridad de la IA. (Riccardo Milani/Hans Lucas/AFP vía Getty Images)

Protección para los niños

Mientras los gobiernos, las escuelas y las empresas estén dispuestos a experimentar con tecnologías de IA sin saber realmente cuáles serán los resultados, hay buenas razones para mostrarse escépticos con respecto a la IA en las aulas, dijo Allen.Algunos profesores abogan por el regreso de los exámenes orales, las pruebas Blue Book o el uso de procesadores de texto con acceso limitado a Internet por parte de los estudiantes, dijo Allen. "En esta etapa temprana del experimento con la IA, eso va a ser positivo para quienes lo hagan".

Dijo que es posible que las escuelas creen sistemas de IA esterilizados y exclusivamente académicos.

"Esa va a ser la norma en el futuro", afirmó Allen. "No me preocuparía necesariamente por que tu IA educativa se descarrile y te ofrezca pasajes del marqués de Sade".

Allen afirma que existen tres niveles de resistencia a la hora de proteger a los niños y sus capacidades de pensamiento crítico: La elección personal, las políticas institucionales y la acción política o legal.

En el nivel de la elección personal, los padres que viven en Estados Unidos y otras "sociedades más o menos libres" se enfrentarán a la cuestión de cómo educar a sus hijos, afirmó.

"Los padres tienen la opción de someter a sus hijos a este experimento o de no matricularlos en escuelas que están pasando a ser totalmente digitales o incluso híbridas", afirmó.

A nivel institucional, las escuelas pueden elegir entre adoptar plenamente la IA o implementar algún tipo de sistema parcial o híbrido, afirmó Allen.

Una estudiante levanta la mano durante una clase en la escuela primaria Tussahaw en McDonough, Georgia, el 4 de agosto de 2021. (Brynn Anderson, Archivo/Foto AP)

Una estudiante levanta la mano durante una clase en la escuela primaria Tussahaw en McDonough, Georgia, el 4 de agosto de 2021. (Brynn Anderson, Archivo/Foto AP)"Esas serán decisiones críticas en el futuro", dijo. "Se trata de un experimento, por lo que básicamente serán grupos de control", afirmó.

Hasta ahora, la perspectiva de restringir la IA en las aulas estadounidenses a través de los sistemas políticos y legales "no parece muy esperanzadora" más allá del ámbito estatal, dijo, pero la resistencia a la IA está creciendo entre grupos coordinados de padres en Estados Unidos y otros países.

Australia, por ejemplo, pretende construir enormes centros de datos y abrir los datos de los australianos para su uso en el entrenamiento de la IA, pero sus políticas para restringir los teléfonos inteligentes en las escuelas y exigir la verificación de la edad para las redes sociales son "correctas en cuanto a la dirección", afirmó Allen.

"De hecho, hay países enteros, como Australia, que están haciendo todo lo posible por restringir la exposición digital de los niños pequeños, desde prohibir los teléfonos móviles en las escuelas hasta criar a los niños sin ningún tipo de tecnología", afirmó. "Por lo tanto, el grupo de control es saludable".

Kroner especula que la IA hará que algunos niños rechacen aún más la autoridad de los profesores y los padres. Anima a los padres a dar ejemplos del mundo real cuando los niños planteen preguntas.

"Los niños pueden escuchar y dar su opinión y, en cierto modo, dejar de lado la IA", dijo Kroner, subrayando que lo que falta en el mundo actual es más interacción humana y conversación y no "respuestas prefabricadas al alcance de la mano".

También existe la posibilidad de que los niños educados para considerar los sistemas de IA como profesores superiores, especialmente en lugares donde escasean los buenos profesores humanos, puedan superar a los que no utilizan la IA, afirma Allen.

"Y eso se debe en parte al hecho de que la cultura digital es tan predominante que adaptarse significa básicamente adaptarse a unas normas en constante evolución que se imponen desde arriba a la población", afirma.

"Así que no se trata de una evolución natural. No es darwiniano en el sentido original, pero es una incógnita cuáles serán los resultados. Simplemente no lo sabemos. Es un experimento".

Únase a nuestro canal de Telegram para recibir las últimas noticias al instante haciendo click aquí