La inteligencia artificial (IA) se ha comercializado como un todo, desde una revolución de la productividad hasta un tomador de decisiones casi autónomo.

Sin embargo, a medida que las herramientas de IA se integran en las operaciones diarias, aumentó la preocupación por lo que ocurre cuando las promesas no se cumplen tras la compra de productos de IA.

Desde afirmaciones exageradas sobre la precisión hasta métricas de rendimiento opacas, algunos se preguntan: ¿Qué recursos hay cuando los sistemas de IA no cumplen lo prometido?

Esta desconexión llamó la atención de las agencias de protección al consumidor, los abogados y los expertos en IA, que dicen que las afirmaciones de marketing deben aplicarse de forma significativa.

El año pasado, las especulaciones sobre los avances en la IA generativa, una de las versiones más utilizadas de esta tecnología, dieron lugar a lo que Neil Sahota, inventor maestro de IBM y asesor de IA de las Naciones Unidas, denominó "tácticas de marketing falsas".

Este fenómeno se denomina "AI washing" (lavado de IA). De forma similar al concepto de "green washing" (lavado verde), cuando una empresa etiqueta de forma engañosa su producto como respetuoso con el medio ambiente o sostenible, el AI washing se produce cuando las empresas realizan afirmaciones falsas o exageran las capacidades de sus modelos de IA para que parezcan más avanzados, atraer inversiones u obtener una ventaja competitiva en el mercado.

Posteriormente, la Comisión Federal de Comercio (FTC) encabezó iniciativas para que las empresas de IA rindan cuentas por sus productos. En 2024, la agencia presentó la Operación AI Comply, que anunció medidas policiales contra las empresas que utilizan el "bombo publicitario de la IA".

La iniciativa tenía por objeto acabar con el uso de herramientas de IA para "engañar, confundir o defraudar a las personas".

"La FTC se centra en garantizar que las empresas de IA puedan innovar rápidamente, al tiempo que se preserva la seguridad y la objetividad de las plataformas de IA, de acuerdo con el Plan de Acción del Presidente en materia de IA", declaró Christopher Bissex, subdirector de Relaciones Públicas de la FTC, a The Epoch Times.

Bissex dijo que algunas de las medidas recientes de la agencia incluyen órdenes contra empresas que realizan afirmaciones falsas sobre la precisión o la eficacia de sus productos de IA, demandas contra empresas que realizaron afirmaciones falsas en sus campañas de marketing y la realización de un estudio para recopilar información sobre cómo las empresas están abordando los riesgos potenciales de los chatbots de IA, especialmente cuando hay niños involucrados.

La página de búsqueda Deepseek se muestra en un teléfono móvil en Londres el 29 de enero de 2025. A medida que la adopción de la IA crece rápidamente, también lo hace el fenómeno del «AI washing», en el que las empresas realizan afirmaciones falsas o exageradas sobre las capacidades de sus modelos de IA para parecer más avanzadas y atraer inversiones o ventajas de mercado. (Leon Neal/Getty Images)

La página de búsqueda Deepseek se muestra en un teléfono móvil en Londres el 29 de enero de 2025. A medida que la adopción de la IA crece rápidamente, también lo hace el fenómeno del «AI washing», en el que las empresas realizan afirmaciones falsas o exageradas sobre las capacidades de sus modelos de IA para parecer más avanzadas y atraer inversiones o ventajas de mercado. (Leon Neal/Getty Images)Marcos legales

Christopher Trocola, fundador de la empresa de ciberseguridad ARC Defense Systems, afirma que la falta de responsabilidad no se debe a la ausencia de regulación."Se debe a la falta de comprensión de que las leyes existentes ya se aplican a la IA. Las empresas piensan que, como no hay legislación específica sobre la IA, no son responsables", explica a The Epoch Times.

Trocola comprende los escollos de las industrias emergentes y está creando marcos de cumplimiento de la IA después de ver cómo los mismos "patrones de fracaso" casi colapsaron la industria solar en 2017. En aquel entonces, dirigió una consultoría de cumplimiento que protegió millones en contratos mientras colaboraba con la FTC.

En la actualidad, como él mismo dice, "me aseguro de que la IA no se coma a la gente".

Afirmó que muchas de las regulaciones existentes pueden aplicarse a los modelos de IA.

El verdadero problema, según Trocola, es que "las empresas no comprenden que su IA está generando infracciones de cumplimiento en tiempo real en virtud de leyes que llevan décadas en vigor".

"Las cortes no están esperando a que se aprueben "leyes sobre IA". Están aplicando los marcos existentes en este momento", afirmó.

"Los compromisos voluntarios ofrecen poca protección cuando se infringen las leyes vigentes, y la mayoría de las empresas no tienen un registro de auditoría que demuestre que no han sido negligentes".

Bob Gourley, director de tecnología de la consultora de ciberseguridad e IA OODA, dijo: "Es probable que en los próximos años se apliquen medidas relacionadas con las reclamaciones engañosas, por ejemplo, la protección del consumidor, ya que existen mecanismos establecidos".

Una pantalla muestra ejemplos de vídeos creados por IA, realizados con la aplicación Grok de Xai en Londres el 12 de enero de 2026. (Leon Neal/Getty Images)

Una pantalla muestra ejemplos de vídeos creados por IA, realizados con la aplicación Grok de Xai en Londres el 12 de enero de 2026. (Leon Neal/Getty Images)"Por otro lado, sería difícil hacer cumplir el incumplimiento relacionado con las garantías de seguridad, ya que no existen regulaciones relacionadas con el incumplimiento [de la IA]", declaró Gourley a The Epoch Times.

El abogado fiscal Chad Silver, fundador de Silver Tax Group, dijo que ha visto de primera mano cómo las regulaciones relativas a las promesas de las empresas de IA son problemáticas.

"Los acuerdos voluntarios de autorregulación entre los gigantes tecnológicos y el gobierno no tienen ahora fuerza legal en la legislación federal", declaró Silver a The Epoch Times. "Mi equipo es testigo de cómo los desarrolladores de software aseguran el cumplimiento de las obligaciones fiscales y evaden con acuerdos de licencia agresivos que eximen a las empresas de toda responsabilidad. Estas empresas afirman que sus algoritmos se ajustan a las directrices del IRS, pero no pueden generar registros de auditoría cuando la agencia les cita formalmente".

Silver añadió: "Salimos de una deuda de USD 167 mil, ya que demostramos que un cliente actuaba siguiendo el consejo de un sistema automatizado que le proporcionaba información falsa. La mejor forma de rendir cuentas hasta ahora es el litigio, ya que las cortes ordenan la divulgación de pruebas y conceden indemnizaciones reales a los consumidores estafados".

En 2025, el proyecto de investigación del Instituto Tecnológico de Massachusetts, "Agentes de IA en red en una arquitectura descentralizada", reveló que, a pesar de los más de USD 40 mil millones invertidos en IA generativa, el 95 por ciento de las empresas no obtenían ningún rendimiento de su inversión.

A partir de una revisión sistemática de más de 300 iniciativas de IA, entrevistas con 52 organizaciones y respuestas a encuestas de 153 líderes del sector, el análisis de Massachusetts ofreció una visión aleccionadora de la realidad de la IA más allá de las campañas de marketing.

Un análisis de RAND Corporation arrojó resultados similares y descubrió que más del 80 por ciento de los proyectos de IA fracasan, el doble de la tasa de fracaso de los proyectos de TI que no son de IA.

Los defensores de los productos de IA señalan la falta de comprensión por parte de los directivos y las métricas sesgadas para medir el éxito de la tecnología tras su implementación. La plataforma de revisión de software y servicios G2 publicó un estudio que indicaba que el 57 por ciento de las empresas ya cuentan con agentes de IA en producción —no en fase piloto— y demostraron un ciclo corto entre la prueba y la ampliación de la tecnología.

En una vista aérea, se ve una valla publicitaria de una empresa de inteligencia artificial (IA) en San Francisco el 16 de septiembre de 2025. El abogado fiscalista Chad Silver afirmó que ha visto de primera mano cómo las regulaciones relativas a las promesas de las empresas de IA son problemáticas. (Justin Sullivan/Getty Images)

En una vista aérea, se ve una valla publicitaria de una empresa de inteligencia artificial (IA) en San Francisco el 16 de septiembre de 2025. El abogado fiscalista Chad Silver afirmó que ha visto de primera mano cómo las regulaciones relativas a las promesas de las empresas de IA son problemáticas. (Justin Sullivan/Getty Images)Además, el análisis de G2 señaló que el 83 por ciento de los compradores encuestados indicaron que estaban satisfechos con el rendimiento de su agente de IA.

Por el contrario, Boston Consulting Group realizó un estudio el año pasado con más de 1250 empresas de todo el mundo y descubrió que solo el 5 por ciento veía el valor de la IA a gran escala. Además, el 60 por ciento de las empresas dijeron que no estaban obteniendo ningún valor material o que reportaban ingresos mínimos a pesar de la "inversión sustancial".

Algunos expertos afirman que una mayor transparencia y auditoría son fundamentales para que las empresas puedan discernir si fueron engañadas en sus inversiones en IA.

"Una auditoría fiable implicaría un examen a nivel de modelo, controles de seguridad, examen de la procedencia y gobernanza organizativa", afirmó Gourley.

"Una auditoría también debería examinar los datos de entrenamiento, el rendimiento, los sesgos, la robustez frente al uso indebido y las estrategias de mitigación de riesgos", añadió. "La auditoría debería realizarse de forma periódica, por ejemplo, una vez al año, con una parte destinada al resumen público, mientras que las cuestiones específicas de la organización no se divulgarían, ya que constituyen secretos comerciales".

Trocola cree que es necesario cambiar el método de auditoría de la IA.

"El enfoque actual es retrógrado. Todo el mundo está auditando la "gobernanza de la IA", lo que significa supervisar a los empleados que utilizan la IA. Es un objetivo erróneo. Tenemos que auditar la seguridad de la IA: lo que hace la propia IA".

Stand de una empresa de software durante el proyecto especial de estudios competitivos AI+Expo en Washington, el 2 de junio de 2025. A medida que avanza la tecnología de IA, su uso en el trabajo administrativo de las empresas ha crecido; sin embargo, estudios recientes muestran que muchas empresas informan de un rendimiento material escaso o nulo a pesar de la importante inversión realizada. (Madalina Vasiliu/The Epoch Times)

Stand de una empresa de software durante el proyecto especial de estudios competitivos AI+Expo en Washington, el 2 de junio de 2025. A medida que avanza la tecnología de IA, su uso en el trabajo administrativo de las empresas ha crecido; sin embargo, estudios recientes muestran que muchas empresas informan de un rendimiento material escaso o nulo a pesar de la importante inversión realizada. (Madalina Vasiliu/The Epoch Times)Afirmó que este tipo de auditoría debería incluir aspectos como la deriva de la IA, es decir, la degradación gradual del rendimiento y la precisión de un modelo de IA a lo largo del tiempo, incluyendo alucinaciones, fugas de información y sesgos.

"Por eso fracasan entre el 70 y el 80 por ciento de los proyectos de IA empresariales. Controlan lo que no deben", afirmó Trocola.

Silver cree que son necesarias las auditorías de rendimiento realizadas por terceros.

"El entorno normativo de un proveedor de modelos [de IA] pionero es hostil, ya que las leyes estatales les obligan a informar sobre el consumo energético anual y los conjuntos de entrenamiento", afirmó. "Los terceros deben auditar los pesos y sesgos de un modelo cada seis meses, y esto debe ser creíble".

Gourley se mostró inflexible sobre la importancia de la transparencia de la IA.

"Las normas deben ser específicas en cuanto a la documentación del diseño del modelo, las fuentes de datos, las limitaciones, el análisis de riesgos y los planes de mitigación, que deben adaptarse a cada uno de los ámbitos de alto impacto", afirmó.

Cree que la certificación debe ser facilitada por un organismo híbrido o una agencia pública estadounidense, como el Instituto Nacional de Estándares y Tecnología, o por reguladores de IA que colaboren con expertos independientes.

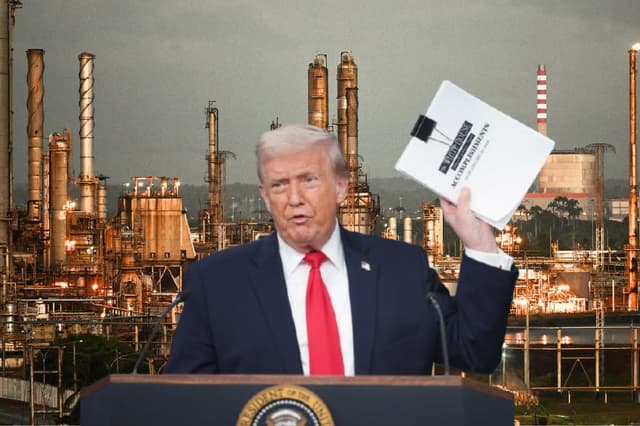

El 11 de diciembre de 2025, la Casa Blanca publicó la orden ejecutiva "Garantizar un marco normativo nacional para la inteligencia artificial", que prometía una estructura reguladora "mínimamente gravosa" que incluye un grupo de trabajo sobre litigios relacionados con la IA, la evaluación de las leyes estatales sobre IA y posibles normas federales de información y divulgación.

El presidente Donald Trump muestra una orden ejecutiva firmada en el Despacho Oval el 11 de diciembre de 2025. La orden ejecutiva limita la capacidad de los estados para regular la inteligencia artificial, algo por lo que la industria tecnológica ha estado presionando. (Alex Wong/Getty Images)

El presidente Donald Trump muestra una orden ejecutiva firmada en el Despacho Oval el 11 de diciembre de 2025. La orden ejecutiva limita la capacidad de los estados para regular la inteligencia artificial, algo por lo que la industria tecnológica ha estado presionando. (Alex Wong/Getty Images)Los investigadores del Instituto de Inteligencia Artificial Centrada en el Ser Humano de la Universidad de Stanford predijeron que, tras años de "apuestas millonarias", 2026 podría ser un año decisivo para la IA: cuando se analice minuciosamente su utilidad real.

"El año que viene exigirá rigor por encima del bombo publicitario", afirmaba un artículo de Stanford. "La pregunta ya no es "¿Puede la IA hacer esto?", sino "¿Qué tan bien, a qué costo y para quién?"".

En diciembre de 2025, el Foro Económico Mundial afirmó que, si 2025 fue el año del "entusiasmo por la IA", este año podría ser el año de su "ajuste de cuentas".